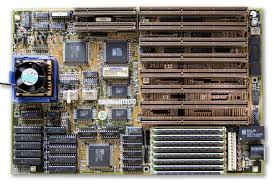

Fue creada en 1983 por IBM para su primer ordenador, se utilizó solo los primeros años, el único externo que tenia era el conector DIN para el teclado.

Esta basado en el PC AT de IBM, fue la evolución del XT aunque su único conector segia siendo el del teclado, aunque todos los puesto de E/S estaban cableados a la placa base en la parte posterir de la caja o instaladas como targetas adaptadoras. Las Baby-AT son mas paqueñas que la At.

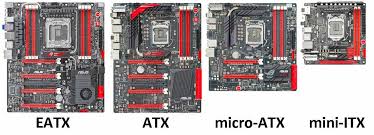

Fue introducido por Intel en 1995, antualmente son de las mas usadas ya que es más conectores externos, el taclado y ratón se conectan po PS/2, la Mini-ATX y Micro-ATX son más pequeñas que la ATX y Flex-ATX y Extended-ATX son más grades que la ATX.

Fue creada en 2001 por la empresa VIA, esta diseñadas para montarlas en equimos más pequeños.

Fue creado por Intel en 1998 para servidores y empresas con múltiples microprocesadores y discos duros.

Fue desarrollado en 1990 por Western Digital y NLX fue desarrollado en 1996 por Intel.

Fue creado por Ampro y Motorola, las placas ETX llevan integrado el procesador, la memoria y las entradas y salidas, posee versiones más reducidas como Nano-ETX y XTX.

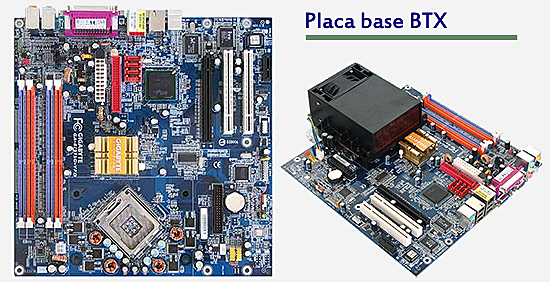

Fue introducido en 2004 por Intel para resolver el problema de refrigeración en las placas ATX, pero tuvo muy poca aceptación.

Fue creado en 2007 por AMD su factor de forma es abierto y escompatible con ATX.

| Nombre | Medidas |

|---|---|

| XT | 330 mm x 240 mm |

| AT | 305 mm x 244 mm |

| Baby-AT | 280 mm x 210 mm |

| ATX | 305 mm x 244 mm |

| Mini-ATX | 284 mm x 208 mm |

| Micro-ATX | 244 mm x 244 mm |

| Flex-ATX | 229 mm x 191 mm |

| Extended-ATX | 305 mm x 330 mm |

| ITX | 170 mm x 170 mm |

| Mini-ITX | 170 mm × 170 mm |

| Nano-ITX | 120 mm × 120 mm |

| Pico-ITX | 100 mm × 72 mm |

| Mobile-ITX | 60 mm × 60 mm |

| WTX | 356 mm × 425 mm |

| SWTX | 425 mm × 508 mm |

| LPX | 330 mm × 229 mm |

| NLX | 254 mm × 228 mm hasta 254 mm × 345 mm |

| ETX | 114 mm × 95 mm |

| Nano-ETX | 84 mm × 55 mm |

| XTX | 114 mm × 95 mm |

| BTX | 325 mm × 267 mm |

| Micro-BTX | 264 mm × 267 mm |

| Pico-BTX | 203 mm × 267 mm |

| DTX | 203 mm × 244 mm |

| Mini-DTX | 203 mm × 170 mm |

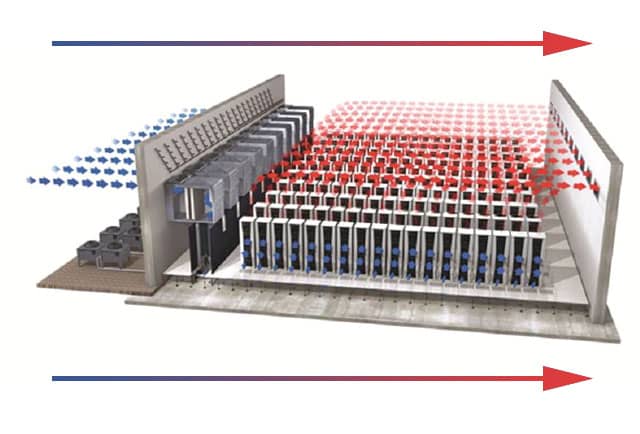

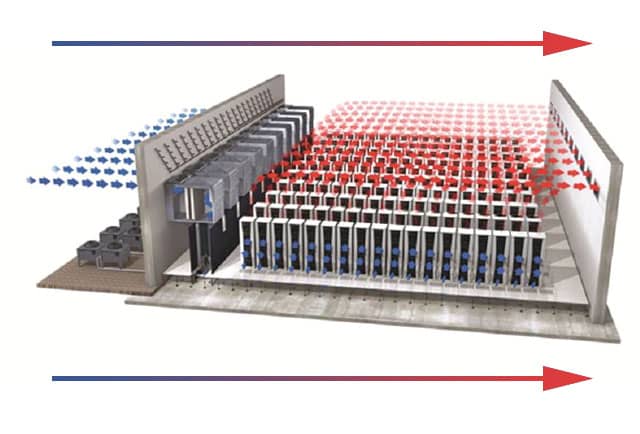

Algunas de las pricipales ventajas son: mejor gestión del flujo y refrigeració, disposición más eficiente de los componentes, mejor soporte para componentes de alta potencia, reducción del ruido, evolución del diseño interno del chasis y mayor estabilidad en sistemas con múltiples componentes.

UPC: 1 ranura PCI Express x16, que es compatible con PCIe 3.0 y funcionando a x16

COnjunto de chips: 1 ranura PCI Express x16, que es compatible con PCIe 3.0 y funcionando a x16

AMD Socket AM4, compatible con: procesadores AMD Ryzen™ 5000 serie G/procesadores AMD Ryzen™ serie 5000/procesadores AMD Ryzen™ 4000 serie G/procesadores AMD Ryzen™ 3000 y Ryzen™ 3000 serie G

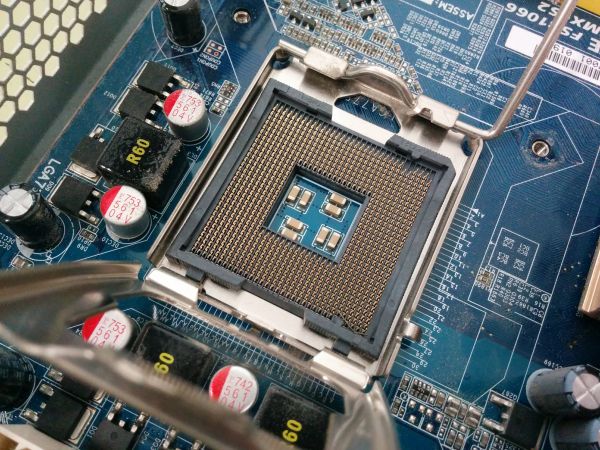

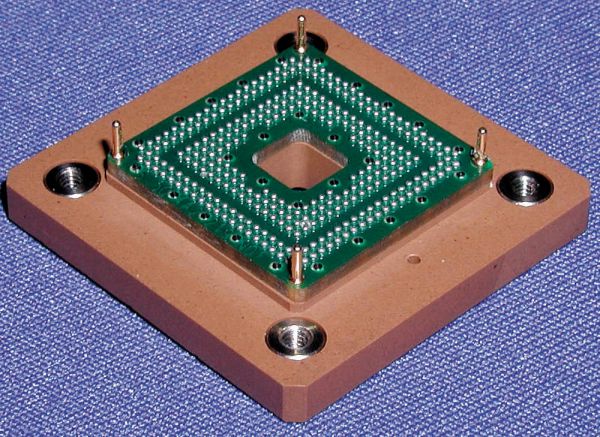

PGA (Pin Grid Array): Este zócalo se caracteriza por poseer conectores donde se insertan los pines del microprocesador. En sus primeras versiones se fijaba el microprocesador mediante un tornillo existente en el lateral del zócalo y por presión con el disipador. Posteriormente evolucionó al añadirse una palanca junto al zócalo que permitía bloquear los pines del microprocesador una vez introducido para evitar que se mueva. Esta tecnología se denominó ZIF (Zero Insertion Force). En algunas sitios podemos llegar a ver como que ZIF es un zócalo al igual que el PGA, pero lo más correcto es decir que ZIF es una tecnología que se introdujo en el zócalo PGA. Un ejemplo de PGA es el zócalo AM4 para microprocesadores de AMD.

LGA (Land Grid Array): Este zócalo invierte el anterior, ya que es el zócalo de la placa base el que ahora va a poseer los pines, mientras que el microprocesador tendrá zonas de contacto con estos pines. De esta manera se evita que se dañen los pines del microprocesador. Este zócalo también incorpora la tecnología ZIF (Zero Insertion Force) que incluye la palanca y un cuadrado metálico de protección para evitar que el microprocesador se mueva. Un ejemplo de LGA es el zócalo LGA1700 para microprocesadores Intel.

BGA (Ball Grid Array): En este zócalo existen unas bolitas cobre que se sueldan directamente a la placa base. Elimina cualquier posibilidad de ampliación o sustitución del microprocesador por parte del usuario, sólo siendo posible en algunas ocasiones con técnicas de soldadura especializada. Es el más utilizado en equipos portátiles, debido a su pequeño tamaño y su mayor refrigeración.

Slot: Totalmente diferente a los anteriores. Se trata de de un rectángulo similar a las ranuras de expansión. Utiliza contactos (y no pines como los anteriores) para la transmisión de datos y electricidad. Se ayuda de unas pestañas de sujeción laterales para que no se mueva. Está obsoleto, sólo lo utilizó Intel en los microprocesadores Celeron, Pentium II y Pentium III.

| Zócalo | Ventajas | Desventajas |

|---|---|---|

| Zócalo PGA |

|

|

| Zócalo LGA |

|

|

| Zócalo BGA |

|

|

| Zócalo Slot |

|

|

Pues la pasta termica se utiliza para mejorar la transferencia de calor entre la CPU/GPU y su disipador. En resumen la pasta termica ayusçda a mantener las termperaturas adecuadas y evitar el sobrecalentaniento.

Sirve como un disipador de calor y protección para el chip. Ayuda a distribuir el calor generado y evita daños físicos.

Generalmente, las fuentes de alimentación proporcionan varios voltajes, como 3.3V, 5V y 12V, que son estándar para diferentes componentes del ordenador.

Es un procesador adicional que trabaja junto con la CPU principal para manejar tareas específicas, como cálculos matemáticos complejos o procesamiento gráfico.

Es un firmware que inicia el hardware del ordenador durante el arranque y proporciona servicios básicos de entrada/salida

Es el procesador dedicado a renderizar gráficos y video. Se encarga de los cálculos necesarios para mostrar imágenes en pantalla.

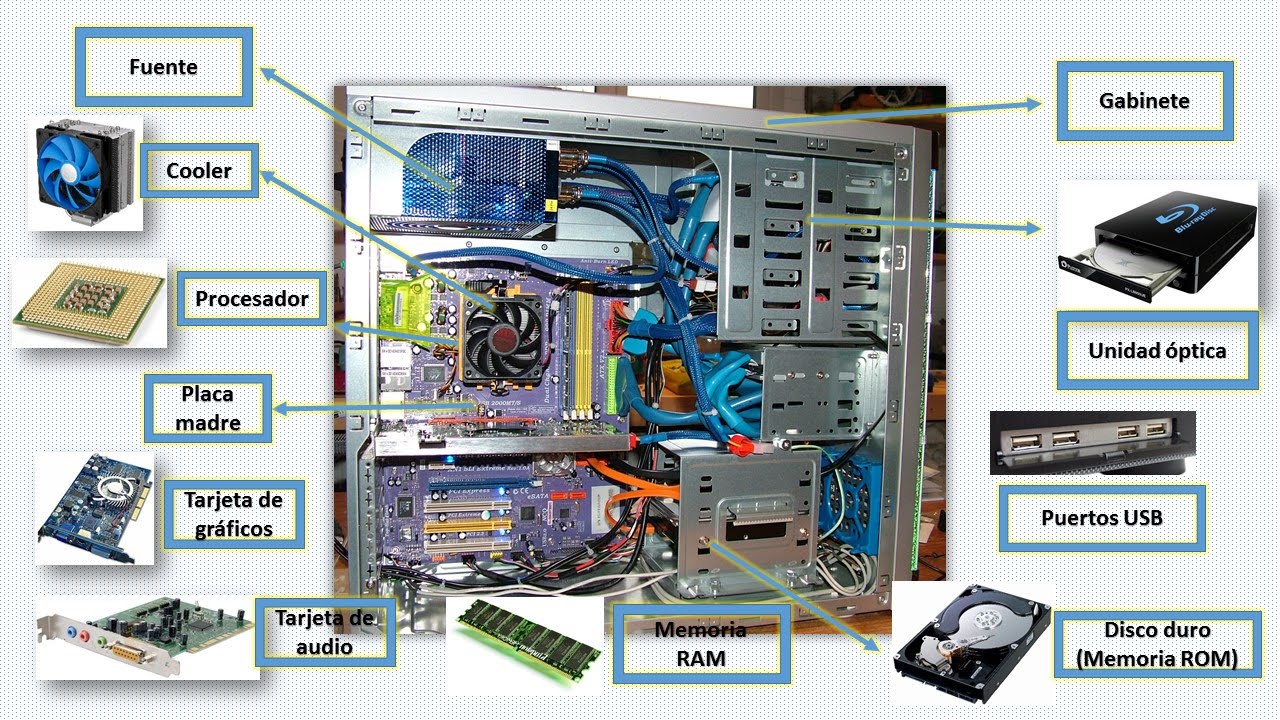

Pues que la placa base es donde se conectan todos los componentes como la RAM, mientras que la targeta gráfica es un componente especifico diseñado para manejar el procesamiento de graficos.

| Características | Valor |

|---|---|

| Factor de forma | Micro ATX |

| Procesadores compatibles | 8th Generation Intel® Core™ i7 processors/Intel® Core™ i5 processors/Intel® Core™ i3 processors/Intel® Pentium® processors/Intel® Celeron® processors in the LGA1151 package. |

| Socket | LGA1151 |

| Memoria RAM (Tipo) | DDR4 |

| Memoria RAM (Número ranuras) | 2 |

| Memoria RAM (Capacidad máxima) | 32GB |

| Memoria RAM (Velocidades) | 2666/2400/2133 MHz |

| Dual Channel / Quad Channel | Dual Channel |

| Northbrigde Chipset | Intel® H310 Express Chipset |

| Southbrigde Chipset | No especificado |

| Gráfica integrada | Intel® HD Graphics support: 1 x D-Sub port, supporting a maximum resolution of 1920x1200@60 Hz 1 x DVI-D port, supporting a maximum resolution of 1920x1200@60 Hz 1 x HDMI port, supporting a maximum resolution of 4096x2160@30 Hz |

| SATA (Conectores) | 4 |

| SATA (Versión o Velocidad) | 6Gb/s |

| M.2 (Conectores) | 1 |

| Ranuras de expansión (Número y tipo) | 1 x PCI Express x16 slot, running at x16 2 x PCI Express x1 slots |

| Puertos externos | 1 x PS/2 keyboard port 1 x PS/2 mouse port 1 x D-Sub port 1 x DVI-D port 1 x HDMI port 2 x USB 3.1 Gen 1 ports 4 x USB 2.0/1.1 ports 1 x RJ-45 port 3 x audio jacks |

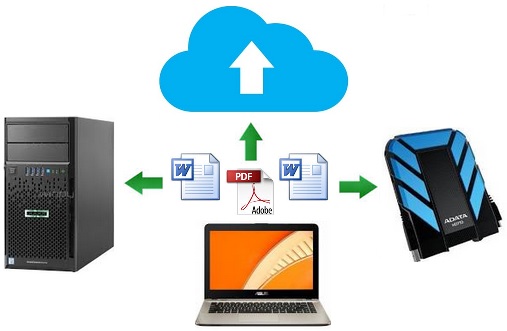

La función principal de un Centro de Procesamiento de Datos (CPD) es gestionar, almacenar y procesar grandes volúmenes de información de manera eficiente y segura. Un CPD proporciona la infraestructura necesaria para el funcionamiento de servidores, sistemas de almacenamiento y redes, permitiendo el acceso y la disponibilidad de datos para aplicaciones y servicios.

Además, se encarga de asegurar la continuidad del servicio, la protección de datos y la recuperación ante desastres, garantizando que la información esté disponible para los usuarios y las organizaciones en todo momento.

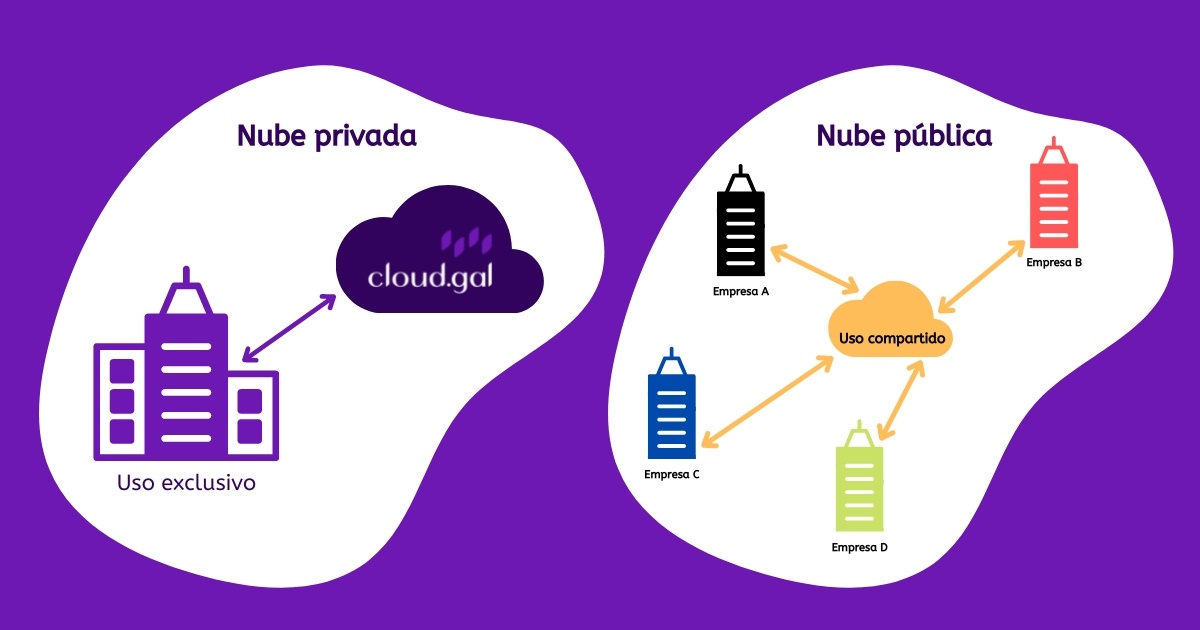

Desde la presgectiva de marketing como una solucion tectológica que permite accerder, almacemar y gestionasdatos y servicios en cualquier momento y lugar, que elimina la necesidad de infraestructuas fisicas costosas.

| Nube Pública | Nube Privada | |

|---|---|---|

| Infraesstructura | Compartida ente múltuplies usuarios/organizaciones | Exclusiva para una sola organización |

| Costo | Más económica, modelo de pago por uso | Más costosa. requiere inversión en hardware/infraestructura |

| Escalabilidad | Altamente escalable según la demanda | Limitada a los recursos de la infraestructura interna |

| Seguridad | Seguridad robusta pero compartida | Mayor control y personalización en seguridad |

| Mantenimiento | Gestionada por el proveedor | Gestionada irnernamente o por el proveedor dedicadido |

| Flexibilidad | Estándar,menos personalizable | Altamente personalizadable según necesidades |

| Implementación | Rápida y secilla | Puede ser más compleja y lenta |

Para una empresa pequeña seria generalmente la nube pública es más apropiada por varios motivos, como el costo, el mantenimiento, escalabilidad y implementación rápida

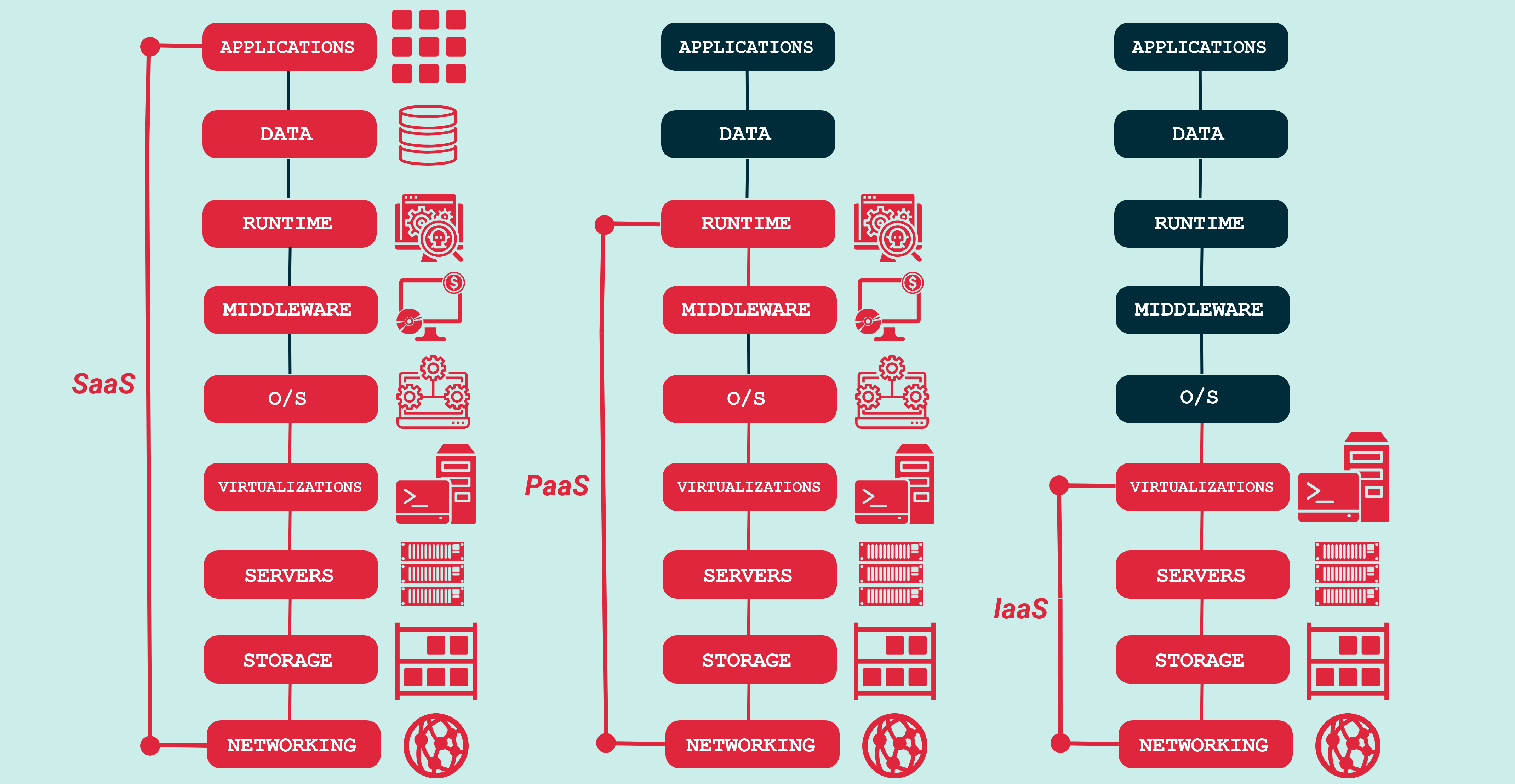

Los servicios de SaaS son más costosos porque incluyen costos ocultos relacionados con la infraestructura, mantenimiento, soporte y actualizaciones continuas. A cambio, ofrecen una experiencia más sencilla y eficiente para el usuario, que puede enfocarse en sus actividades principales sin preocuparse por los aspectos técnicos.

IaaS se refiere a un modelo de computación en la nube en el que el proveedor ofrese recursos informáticos virtualizados, como por ejemplo servidores, almacenamiento e infraestructura de red, a cambio de un pago por el uso.

Paas es un modelo de computación en la nube en el que el proveedor ofrece una plataforma para desarrolar, ejecutar y administras aplicaciones incluida la infraestructura y el middleware subyacentes.

FaaS un modelo de computaciónsin servidor en el que el proveedor ofrece una plataforma para ejecutar código en respuesta a eventos, sin necesidad de administar ninguna infraestructura.

IaaS es ideal para empresas que desean mantener el control sobre su infraestructura y aplicaciones mientras externalizan el mantenimiento. PaaS es ideal para empresas que desean centrarse en el desarrollo y la implementación de aplicaciones sin preocuparse por la administración de la infraestructura. FaaS es ideal para empresas que desean crear e implementar aplicaciones basadas en eventos de manera rápida y eficiente, sin preocuparse por la administración o el escalado de servidores.

Las máquinas virtuales (VMs) se utilizaron inicialmente en sistemas de mainframe para ejecutar múltiples sistemas operativos en una sola máquina física. El primer software comercial de VM, VMware, se lanzó en 1999, permitiendo a los usuarios ejecutar múltiples sistemas operativos basados en x86 en una sola máquina física. Las VMs se usaron principalmente para desarrollo, pruebas y soporte de sistemas heredados.

Las VMs se adoptaron más ampliamente, impulsadas por la necesidad de consolidación de servidores y una mejor utilización de recursos. VMware, Virtual Iron y XenSource fueron algunos de los principales proveedores de VMs. Se centraron principalmente en la virtualización de servidores, con un enfoque en la reducción de costos de hardware y la mejora de la eficiencia de TI.

La introducción de hipervisores como VMware ESX, Microsoft Hyper-V y Citrix XenServer permitió una virtualización más eficiente y escalable. Las VMs comenzaron a admitir características más avanzadas, como la migración en vivo, alta disponibilidad y asignación de recursos. La computación en la nube comenzó a emerger, con las VMs desempeñando un papel clave en las ofertas de Infraestructura como Servicio (IaaS).

La computación en la nube se volvió más común, con las VMs en el corazón de las infraestructuras de nube pública, privada y híbrida. Las VMs se optimizaron para entornos de nube, con características como escalado automático, balanceo de carga y aprovisionamiento autoservicio. El auge de OpenStack, una plataforma de nube de código abierto, aceleró aún más la adopción de VMs en entornos de nube.

La aparición de tecnologías de contenerización como Docker, Kubernetes y rkt introdujo una nueva forma de desplegar aplicaciones, desafiando los enfoques tradicionales basados en VMs. La computación sin servidor, liderada por AWS Lambda, Google Cloud Functions y Azure Functions, permitió modelos de función como servicio impulsados por eventos, reduciendo la necesidad de VMs en ciertos escenarios.

La creciente adopción de la computación en el borde, IoT y redes 5G está impulsando la necesidad de VMs más eficientes, ligeras y seguras. El auge de la inteligencia artificial (IA) y el aprendizaje automático (ML) está llevando al desarrollo de VMs impulsadas por IA, que pueden optimizar la asignación de recursos y mejorar el rendimiento. El cambio continuo hacia aplicaciones y servicios nativos de la nube está impulsando la necesidad de una gestión de VMs más flexible, escalable y automatizada.

Netflix es un buen ejemplo de éxito en el uso de la nube debido a su capacidad para escalar, innovar y mejorar la experiencia del usuario. Su evolución de un modelo de negocio de alquiler de DVDs a un gigante del streaming y la producción de contenido original demuestra cómo la adopción de tecnologías en la nube puede transformar una empresa y permitirle prosperar en un entorno competitivo.

Se están desplazándose hacia el norte geográficamente por varias razones. Una de las principales es la búsqueda de climas más fríos, que permiten una mejor eficiencia energética en la refrigeración de los equipos. Las temperaturas más bajas reducen la necesidad de sistemas de refrigeración intensivos, lo que a su vez disminuye el consumo energético y los costos operativos, aunque también se ofrece ventajas en términos de escalabilidad, seguridad y rapidez de implementación.

Es un dispositivo que proporciona energía eléctrica a los equipos conectados en caso de un corte de energía o fluctuaciones en la red eléctrica. Su función principal es garantizar que los sistemas críticos, como servidores y equipos de red en un Centro de Procesamiento de Datos (CPD), sigan funcionando sin interrupciones.

Los SAI como los grupos electrógenos son componentes esenciales para la operación eficiente y segura de un CPD, garantizando la disponibilidad continua de energía y protegiendo los equipos críticos de posibles daños.

La seguridad contra incendios en un Centro de Procesamiento de Datos (CPD) es fundamental para proteger la infraestructura crítica, los datos y la continuidad del negocio. Las pricipales medidas de seguridad contra incendios son:

Se evita el uso de agua debido a los riesgos asociados con el daño a los equipos y la infraestructura crítica.

La gestión de los racks de servidores en un Centro de Procesamiento de Datos (CPD) es esencial para garantizar un funcionamiento eficiente y seguro de los equipos. Esto implica un enfoque cuidadoso en la regulación de la temperatura y la optimización del espacio. En cuanto a temperatura y espacio es crucial para optimizar el rendimiento, prolongar la vida útil de los equipos y garantizar la continuidad del servicio. La combinación de buenas prácticas en el diseño, monitoreo y mantenimiento contribuye a un entorno de trabajo más eficiente y seguro.

La limpieza y la ausencia de polvo en un CPD son fundamentales para garantizar el rendimiento, la fiabilidad y la seguridad de los equipos. Un ambiente limpio no solo previene problemas técnicos y prolonga la vida útil del hardware, sino que también mejora la calidad del aire y la salud del personal que trabaja en el entorno. Por lo tanto, implementar y mantener prácticas de limpieza efectivas es una parte esencial de la gestión de un CPD.

Tipor de riesgos:

Medidas de seguridad:

El backaup es importante para la protección contra pérdida de datos, continuidad del negocio ya que permite restaurar rápidamente las operaciones y minimizar el tiempo de inactividad.

El stock de piezas es importante para el mantenimiento, reparación rápida, prevención de interrupciones

Por las siguientes razónes:

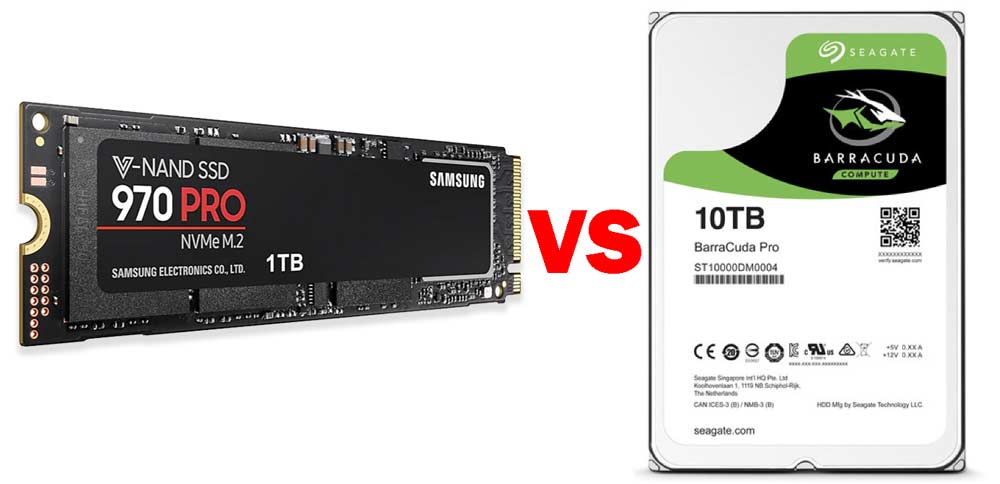

Rendimiento:

Seguridad

El sistema de refrigeración es un componente esencial en la operación de un CPD. Su importancia radica en su capacidad para prevenir el sobrecalentamiento, mantener la eficiencia operativa, prolongar la vida útil del equipo y reducir costos. Un sistema de refrigeración bien diseñado y mantenido no solo mejora el rendimiento del CPD, sino que también contribuye a la seguridad y fiabilidad de las operaciones. Por lo tanto, es fundamental invertir en soluciones de refrigeración adecuadas y realizar un mantenimiento regular para garantizar un entorno de trabajo óptimo para los equipos de TI.

la operación de un CPD implica una variedad de costos que pueden acumularse rápidamente. Desde la inversión inicial en equipos y la infraestructura hasta los costos operativos continuos relacionados con la energía, el mantenimiento, la seguridad y el espacio físico, todos estos factores contribuyen a que la operación de un CPD sea costosa. Las empresas deben considerar cuidadosamente estos costos al planificar y gestionar sus operaciones de TI.

Es un modelo en el que las empresas alquilan espacio en un Centro de Procesamiento de Datos (CPD) para alojar sus propios servidores y equipos de TI.

Ventajas

Las pricipales ventajas son:

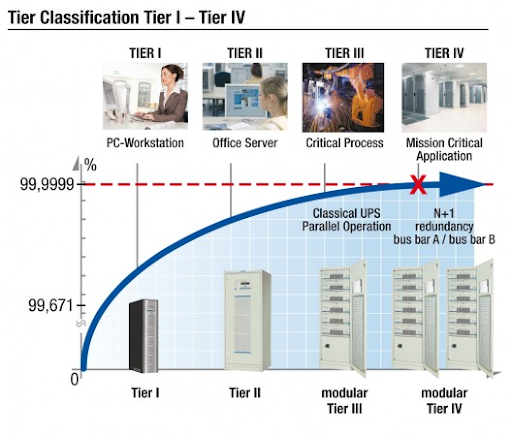

Pues Tier I es el nivel más básico, con una infraestructura simple y mínima redundancia. Tiene una disponibilidad del 99. 671%, lo que significa que puede experimentar tiempos de inactividad anuales de aproximadamente 28.8 días, el Tier II ofrece una mayor disponibilidad y redundancia en comparación con Tier I. Tiene una disponibilidad del 99.749%, lo que se traduce en un tiempo de inactividad anual de alrededor de 22 días, el Tier III permite el mantenimiento concurrente, lo que significa que se pueden realizar tareas de mantenimiento sin interrumpir las operaciones. Tiene una disponibilidad del 99.982%, lo que implica un tiempo de inactividad anual de aproximadamente 1.6 días y el Tier IV es el nivel más alto de disponibilidad y redundancia. Está diseñado para ser tolerante a fallos, lo que significa que puede seguir funcionando incluso si hay fallos en algunos de sus componentes. Tiene una disponibilidad del 99.995%, lo que se traduce en un tiempo de inactividad anual de solo 26.3 minutos.

Tiene un Tier III, tiene una disponibilidad alta con 99.982%

Es crucial porque establece estándares de disponibilidad, redundancia y mantenimiento, lo que ayuda a las organizaciones a seleccionar la infraestructura adecuada según sus necesidades.

| Tier | Ventajas | Desventajas |

|---|---|---|

| Tier I | Costo Bajo Simplicidad |

Baja desponibilidad Sin Redundancia |

| Tier II | Mejor disponibilidad Redundancia parcaial |

Costo moderado Limitaciones en la redundancia |

| Tier III | Alta disponibiloidad Mantenimiento concurrente |

Coste elevado Complejidad |

| Tier IV | Máxima desponibilidad Tolerancia a fallos |

Coste muy elevado Complejidad operativa |

Se utilixa porque tiene una alta velocidad de transmisión, un ancho de bando mejorado, reducción de la interferencia, preparación para el futuro, eficiencia energética.

El cableado en el suelo técnico es crucial para mantener la eficiencia, la seguridad y la organización del entorno del centro de datos.

El término "U" en los racks de un centro de datos (CPD) se refiere a "unidad de rack" (rack unit en inglés) y es una medida estándar utilizada para describir la altura de los equipos que se montan en un rack. Una unidad de rack (1U) equivale a 1.75 pulgadas (44.45 mm) de altura. Por lo tanto, un equipo que ocupa 2U tendrá una altura de 3.5 pulgadas (88.9 mm), y así sucesivamente.

Es fundamental para la organización, la eficiencia y la gestión del espacio. Proporciona un marco estandarizado que permite a los administradores de centros de datos planificar, instalar y mantener equipos de manera efectiva, lo que contribuye a un funcionamiento óptimo del CPD.

Fue el housing como servicio porque nunca habia oido hablar de ello.

Se relaciona porque tienes que saber donde van los componentes, saberlos montar.

No me lo imagino,creo que necesitaría un nivel alto de redes, de mantenimiento y montaje de equuipos, ciberseguridad, conocimiento de las normativas.

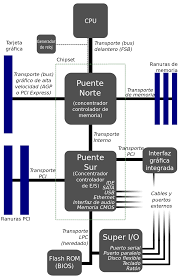

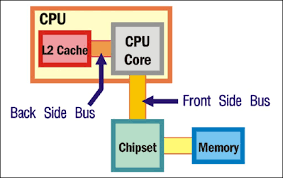

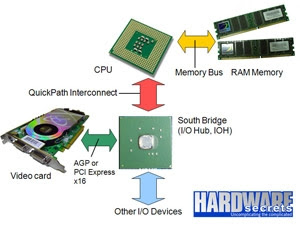

Es responsable de la comunicación entre el procesador, la memoria RAM y las tarjetas gráficas. Su función principal es gestionar el tráfico de datos entre estos componentes de alto rendimiento, asegurando que la CPU tenga acceso rápido a la memoria y a las tarjetas gráficas.

Se encarga de gestionar las conexiones de entrada/salida del sistema. Esto incluye la comunicación con dispositivos como discos duros, puertos USB, tarjetas de sonido y otros periféricos. Aunque también gestiona las interfaces de almacenamiento y proporciona soporte para las tecnologías de red.

Significa "Front Side Bus", su función es permitir la transferencia de datos entre la CPU y otros componentes del sistema, aunque en arquitecturas más recientes ha sido reemplazado por otras tecnologías como DMI o QPI.

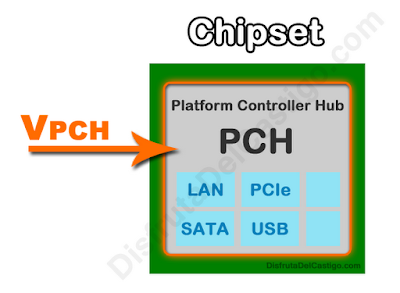

Significa "Platform Controller Hub", tiene muchas funciones que anteriormente estaban distribuidas entre el puente sur y otros controladores, gestionando la comunicación entre el procesador y los dispositivos de entrada/salida, así como funciones de almacenamiento y conectividad.

Significa "Direct Media Interface", su función es permitir una comunicación rápida y eficiente entre el CPU y los dispositivos gestionados por el PCH, mejorando el rendimiento general del sistema al reducir la latencia en la transferencia de datos.

Es una tecnología desarrollada por Intel para permitir la comunicación de alta velocidad entre el procesador y otros componentes del sistema, como la memoria y otros procesadores en sistemas multiprocesador. Se creó para reemplazar el FSB y mejorar el rendimiento en arquitecturas de múltiples núcleos y multiprocesadores. Se utiliza principalmente en procesadores Intel de gama alta, como los de la serie Xeon y Core i7/i9.

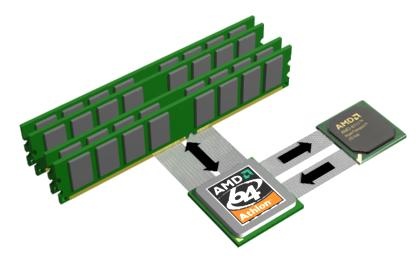

Es una tecnología de interconexión desarrollada por AMD que permite la comunicación de alta velocidad entre el procesador y otros componentes del sistema, como la memoria y las tarjetas gráficas. Se creó para mejorar la eficiencia y el rendimiento en sistemas multiprocesador y se utiliza principalmente en procesadores AMD, como los de las familias Athlon y Opteron.

Encendido del PC: Al presionar el botón de encendido, la BIOS se carga automáticamente.

POST: Realiza el chequeo de hardware.

Configuración: Configura los componentes del sistema.

Carga del SO: Inicia la carga del sistema operativo desde el dispositivo de almacenamiento configurado.

Phoenix: Fabricante de Phoenix-BIOS.

Award: Conocido por Award-BIOS.

AMI (American Megatrends Inc.): Proveedor de AMI-BIOS.

La BIOS está grabada en un pequeño chip de memoria que se encuentra en la placa base del ordenador, el chip es conocido como ROM (Read-Only Memory).

Encender el ordenador o reiniciarlo, prestar atención a los mensajes de inicio, presiones la tecla correcta (Suprimir, F2, ESC, F10) y navegar por el menú.

Entrar en la bios, cargar los valores predeterminados, guardar y salir, revisar la documentación, verificar las conexiones de Hardware y considerar la asistencia técnica.

Configurar una contraseña de supervisor en la BIOS, configurar una contraseña de usuario, en algunos sistema se puede deshabilitar el accose a la BIOS o utilizar un Software que monitoree los cambios en la configuración de la BIOS.

El overclocking es el proceso de aumentar la velocidad a la que un hardware específico, como el procesador o la memoria RAM, funcionan por encima de las especificadas por el fabricante.

Verificar la Configuración en la BIOS: Acceder a la BIOS y ajustar la fecha y hora correctas.

Reemplazar la Batería de la Placa Base:Cambiar la batería agotada (tipo CR2032) en la placa base.

Sincronizar con Internet: Configurar la sincronización automática de la hora con un servidor de tiempo en el sistema operativo.

Comprobar Configuraciones del Sistema Operativo: Asegurarse de que la zona horaria sea correcta

Actualizar el Sistema Operativo: Mantener el sistema operativo actualizado para corregir posibles problemas de hora.

No se puede cambiar el modelo de la BIOS.

Interrupción del Proceso: El corte puede interrumpir la grabación de la BIOS.

Inutilización del Ordenador: Puede dejar la BIOS corrupta, impidiendo que el ordenador arranque.

Necesidad de Reprogramación: Se requerirá asistencia técnica para reprogramar el chip de la BIOS.

Riesgo de Daños: Aunque no suele dañar el hardware, puede resultar en la pérdida de funcionalidad de la placa base.

Copia de Seguridad: Actúa como respaldo de la BIOS principal, permitiendo que el ordenador siga funcionando si la primera falla.

Recuperación de Fallos: Facilita la restauración del sistema en caso de problemas tras una actualización de la BIOS.

Pruebas y Configuraciones: Permite experimentar con ajustes en la BIOS secundaria sin afectar la principal.

Mayor Estabilidad: Aumenta la fiabilidad del sistema y reduce el riesgo de fallos que impidan el arranque.